Qu'est-ce que le scraping web?

Dans le monde concurrentiel d’aujourd’hui, tout le monde cherche des moyens d’innover et d’utiliser les nouvelles technologies.

Le scraping Web (également appelé extraction de données Web ou data scraping) fournit une solution pour ceux qui souhaitent accéder à des données Web structurées de manière automatisée. Le scraping Web est utile si le site Web public à partir duquel vous souhaitez obtenir des données n’a pas d’API, ou s’il en a, mais ne fournit qu’un accès limité aux données.

Dans cet article, nous allons faire la lumière sur le web scraping, voici ce que vous allez apprendre :

Qu'est-ce que le scraping web?

Le scraping Web est le processus de collecte de données Web structurées de manière automatisée. Cela s’appelle aussi l’extraction de données Web. Certains des principaux cas d’utilisation du web scraping incluent la surveillance des prix, l’intelligence des prix, la surveillance des actualités, la génération de prospects et les études de marché, entre autres.

En général, l’extraction de données Web est utilisée par les personnes et les entreprises qui souhaitent utiliser la grande quantité de données Web accessibles au public pour prendre des décisions plus intelligentes.

Si vous avez déjà copié et collé des informations à partir d’un site Web, vous avez effectué la même fonction que n’importe quel grattoir Web, uniquement à une échelle microscopique et manuelle. Contrairement au processus banal et abrutissant d’extraction manuelle de données, le grattage Web utilise une automatisation intelligente pour récupérer des centaines, des millions, voire des milliards de points de données à partir de la frontière apparemment sans fin d’Internet.

Comment utiliser un data scraper ?

Que vous utilisiez vous-même un outil de grattage de données ou que vous externalisiez le travail à un spécialiste de l’extraction de données Web, vous devrez en savoir un peu plus sur les différences entre l’exploration Web et le grattage Web. Tout aussi important, vous devrez comprendre les pièges possibles de l’extraction et comment les éviter. Lisez la suite pour découvrir comment fonctionne le web scraping et comment y parvenir avec succès.

Le scraping Web est populaire

Et cela ne devrait pas être surprenant, car le web scraping fournit quelque chose de vraiment précieux que rien d’autre ne peut : il vous donne des données Web structurées à partir de n’importe quel site Web public.

Plus qu’une commodité moderne, la véritable puissance du web scraping de données réside dans sa capacité à créer et à alimenter certaines des applications professionnelles les plus révolutionnaires au monde. « Transformatif » ne commence même pas à décrire la façon dont certaines entreprises utilisent les données récupérées sur le Web pour améliorer leurs opérations, en éclairant les décisions de la direction jusqu’aux expériences de service client individuelles.

A quoi sert le data scraping ?

L’extraction de données Web – également connue sous le nom de grattage de données – a une vaste gamme d’applications. Un outil de récupération de données peut vous aider à automatiser le processus d’extraction d’informations à partir d’autres sites Web, rapidement et avec précision. Il peut également s’assurer que les données que vous avez extraites sont bien organisées, ce qui facilite leur analyse et leur utilisation pour d’autres projets.

Dans le monde du e-commerce, le web data scraping est largement utilisé pour la surveillance des prix des concurrents. C’est le seul moyen pratique pour les marques de vérifier les prix des produits et services de leurs concurrents, leur permettant d’affiner leurs propres stratégies de prix et de garder une longueur d’avance. Il est également utilisé comme outil par les fabricants pour s’assurer que les détaillants respectent les directives de prix pour leurs produits. Les organismes d’études de marché et les analystes dépendent de l’extraction de données Web pour évaluer le sentiment des consommateurs en suivant les critiques de produits en ligne, les articles de presse et les commentaires.

Il existe une vaste gamme d’applications pour l’extraction de données dans le monde financier. Les outils de grattage de données sont utilisés pour extraire des informations des reportages, en utilisant ces informations pour guider les stratégies d’investissement. De même, les chercheurs et les analystes dépendent de l’extraction de données pour évaluer la santé financière des entreprises. Les compagnies d’assurance et de services financiers peuvent exploiter un riche gisement de données alternatives extraites du Web pour concevoir de nouveaux produits et polices pour leurs clients.

Les applications d’extraction de données Web ne s’arrêtent pas là. Les outils de récupération de données sont largement utilisés dans la surveillance des actualités et de la réputation, le journalisme, la surveillance SEO, l’analyse des concurrents, le marketing basé sur les données et la génération de leads, la gestion des risques, l’immobilier, la recherche universitaire, et bien plus encore.

Travaillez avec les pros du SEO

Audit technique, création de contenu, optimisation SEO...

Les bases du scraping web

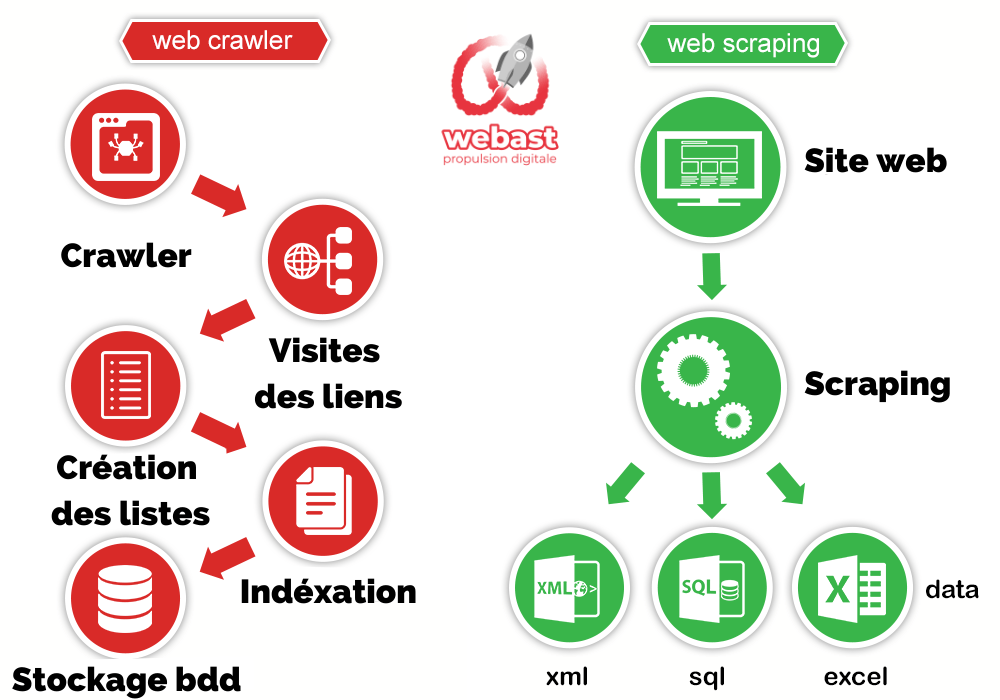

C’est extrêmement simple, en vérité, et fonctionne en deux parties : un robot d’exploration Web et un grattoir Web. Le robot d’indexation est le cheval et le grattoir est le char. Le crawler conduit le scraper, comme à la main, à travers Internet, où il extrait les données demandées. Découvrez la différence entre l’exploration et le scraping Web et leur fonctionnement.

Le robot

Un robot d’exploration Web, que nous appelons généralement une « araignée », est une intelligence artificielle qui navigue sur Internet pour indexer et rechercher du contenu en suivant des liens et en explorant, comme une personne ayant trop de temps libre. Dans de nombreux projets, vous « crawlez » d’abord le Web ou un site Web spécifique pour découvrir les URL que vous transmettez ensuite à votre scraper.

Le scraping

Un grattoir Web est un outil spécialisé conçu pour extraire avec précision et rapidité les données d’une page Web. Les grattoirs Web varient considérablement en termes de conception et de complexité, selon le projet. Une partie importante de chaque scraper est les localisateurs de données (ou sélecteurs) qui sont utilisés pour trouver les données que vous souhaitez extraire du fichier HTML – généralement, XPath, sélecteurs CSS, regex ou une combinaison de ceux-ci sont appliqués.

Qu’est-ce qu’un outil de scraping Web ?

Un outil de grattage Web est un programme logiciel spécialement conçu pour extraire (ou « récupérer ») des informations pertinentes à partir de sites Web. Vous utiliserez presque certainement une sorte d’outil de grattage chaque fois que vous collecterez des données à partir de pages Web par programmation.

Un outil de grattage envoie généralement des requêtes HTTP à un site Web cible et extrait les données d’une page. Habituellement, il analyse le contenu accessible publiquement et visible par les utilisateurs et rendu par le serveur au format HTML.

Parfois, il envoie également des demandes aux interfaces de programmation d’applications (API) internes pour certaines données associées, telles que les prix des produits ou les coordonnées, qui sont stockées dans une base de données et transmises à un navigateur via des requêtes HTTP.

Il existe différents types d’outils de grattage Web, avec des fonctionnalités qui peuvent être personnalisées pour s’adapter à différents projets d’extraction. Par exemple, vous pourriez avoir besoin d’un outil de grattage capable de reconnaître des structures de site HTML uniques, ou d’extraire, de reformater et de stocker des données à partir d’API.

Les outils de scraping peuvent être de grands frameworks conçus pour toutes sortes de tâches de scraping typiques, mais vous pouvez également utiliser des bibliothèques de programmation à usage général et les combiner pour créer un scraper.

Par exemple, vous pouvez utiliser une bibliothèque de requêtes HTTP – telle que la bibliothèque Python-Requests – et la combiner avec la bibliothèque Python BeautifulSoup pour récupérer les données de votre page. Ou vous pouvez utiliser un framework dédié qui combine un client HTTP avec une bibliothèque d’analyse HTML. Un exemple populaire est Scrapy, une bibliothèque open-source créée pour les besoins de scraping avancés.

Le processus de scraping de données Web

Si vous le faites vous-même à l’aide d’outils de scraping de sites Web, voici à quoi ressemble un processus général de scraping Web DIY :

- Identifier le site Web cible

- Collectez les URL des pages dont vous souhaitez extraire les données

- Faire une requête à ces URLs pour obtenir le HTML de la page

- Utilisez des localisateurs pour trouver les données dans le HTML

- Enregistrez les données dans un fichier JSON ou CSV ou dans un autre format structuré

Assez simple, non? Il est! Si vous avez juste un petit projet. Mais malheureusement, vous devez relever de nombreux défis si vous avez besoin de données à grande échelle. Par exemple, maintenir le scraper si la mise en page du site Web change, gérer les proxies, exécuter du javascript ou contourner les antibots. Ce sont tous des problèmes profondément techniques qui peuvent consommer beaucoup de ressources. Il existe plusieurs outils de grattage de données Web open source que vous pouvez utiliser, mais ils ont tous leurs limites. C’est en partie la raison pour laquelle de nombreuses entreprises choisissent d’externaliser leurs projets de données Web.

Si vous externalisez le scraping avec nous

- Notre équipe recueille vos exigences concernant votre projet.

- Notre équipe chevronnée d’experts en web scraping écrit le(s) scraper(s) et met en place l’infrastructure pour collecter vos données et les structurer en fonction de vos besoins.

- Enfin, nous livrons les données dans le format et la fréquence souhaités.

En fin de compte, la flexibilité et l’évolutivité du web scraping garantissent que les paramètres de votre projet, aussi spécifiques soient-ils, peuvent être facilement satisfaits. Les détaillants de mode informent leurs créateurs des tendances à venir sur la base d’informations recueillies sur le Web, les investisseurs chronomètrent leurs positions boursières et les équipes marketing submergent la concurrence avec des informations approfondies, tout cela grâce à l’adoption croissante du Web Scraping en tant que partie intégrante des activités quotidiennes.

Que puis-je utiliser à la place d’un outil de grattage ?

Pour tous les projets, sauf les plus petits, vous aurez besoin d’une sorte d’outil de grattage Web automatisé ou d’un logiciel d’extraction de données pour obtenir des informations à partir de sites Web.

En théorie, vous pouvez couper et coller manuellement des informations de pages Web individuelles dans une feuille de calcul ou un autre document. Mais vous constaterez que cela est laborieux, chronophage et sujet aux erreurs si vous essayez d’extraire des informations de centaines ou de milliers de pages.

Un outil de grattage Web automatise le processus, en extrayant efficacement les données Web dont vous avez besoin et en les formatant dans une sorte de structure bien organisée pour le stockage et le traitement ultérieur.

Une autre voie pourrait être d’acheter les données dont vous avez besoin auprès d’un fournisseur de services de données qui les extraira en votre nom. Cela serait utile pour les grands projets impliquant des dizaines de milliers de pages Web.

Si vous voulez savoir exactement quelles pages sont indexées et lesquelles ne le sont pas, les données sont disponibles sur Google Search Console : Google Search Console < Index < Coverage

Alors, quel type de contenu est indexé (par Google par exemple) ? De nombreux facteurs influents interviennent alors que la première chose à faire est d’écrire du contenu original. La mission de Google est d’offrir un contenu de valeur à ses utilisateurs. C’est presque la même chose pour tous les moteurs de recherche et le contenu dupliqué est toujours la cible de sanctions. Effectuez une recherche d’intention de recherche et de mots-clés. Écrivez et racontez votre propre histoire ou opinion.

Votre stratégie de marketing web

Tout compris, sur mesure, avec une agence web de confiance.

What is web scraping used for?

Renseignements sur les prix

D’après notre expérience, l’intelligence des prix est le plus grand cas d’utilisation pour le web scraping. L’extraction d’informations sur les produits et les prix à partir de sites Web de commerce électronique, puis leur transformation en intelligence est une partie importante des entreprises de commerce électronique modernes qui souhaitent prendre de meilleures décisions de tarification/marketing sur la base de données.

Comment les données de tarification Web et l’intelligence des prix qui peuvent être utiles :

- Tarification dynamique

- Optimisation des revenus

- Veille concurrentielle

- Suivi des tendances produits

- Conformité de la marque et du MAP

Étude de marché

Les études de marché sont essentielles et doivent être guidées par les informations les plus précises disponibles. Des données Web de haute qualité, à volume élevé et très pertinentes, de toutes formes et tailles, alimentent l’analyse de marché et l’intelligence économique dans le monde entier.

- Analyse des tendances du marché

- Tarification du marché

- Optimisation du point d’entrée

- Recherche & Développement

- Veille concurrentielle

Données alternatives pour la finance

Découvrez l’alpha et créez radicalement de la valeur avec des données Web spécialement conçues pour les investisseurs. Le processus de prise de décision n’a jamais été aussi éclairé, ni les données aussi perspicaces – et les plus grandes entreprises mondiales consomment de plus en plus de données extraites du Web, compte tenu de leur incroyable valeur stratégique.

- Extraction d’informations à partir des dépôts auprès de la SEC

- Estimation des fondamentaux de l’entreprise

- Intégrations du sentiment public

- Surveillance de l’actualité

Immobilier

La transformation numérique de l’immobilier au cours des vingt dernières années menace de bouleverser les entreprises traditionnelles et de créer de nouveaux acteurs puissants dans l’industrie. En incorporant des données de produits récupérées sur le Web dans les activités quotidiennes, les agents et les maisons de courtage peuvent se protéger contre la concurrence en ligne descendante et prendre des décisions éclairées au sein du marché.

- Évaluation de la valeur de la propriété

- Surveillance des taux de vacance

- Estimation des rendements locatifs

- Comprendre la direction du marché

Suivi des actualités et du contenu

Les médias modernes peuvent créer une valeur exceptionnelle ou une menace existentielle pour votre entreprise – en un seul cycle d’actualités. Si vous êtes une entreprise qui dépend d’analyses d’actualités en temps opportun, ou une entreprise qui apparaît fréquemment dans les actualités, les données d’actualités de grattage Web sont la solution ultime pour surveiller, agréger et analyser les histoires les plus critiques de votre secteur.

- Prise de décision d’investissement

- Analyse du sentiment public en ligne

- Surveillance des concurrents

- Campagnes politiques

- Analyse des sentiments

Génération de leads

La génération de leads est une activité marketing/vente cruciale pour toutes les entreprises. Dans le rapport Hubspot 2020, 61 % des spécialistes du marketing entrant ont déclaré que générer du trafic et des prospects était leur défi numéro 1. Heureusement, l’extraction de données Web peut être utilisée pour accéder à des listes de prospects structurées à partir du Web.

Veille de marque

Dans le marché hautement concurrentiel d’aujourd’hui, protéger votre réputation en ligne est une priorité absolue. Que vous vendiez vos produits en ligne et que vous ayez une politique de prix stricte que vous devez appliquer ou que vous souhaitiez simplement savoir comment les gens perçoivent vos produits en ligne, la surveillance de la marque avec le web scraping peut vous fournir ce type d’informations.

Automatisation commerciale

Dans certaines situations, il peut être fastidieux d’accéder à vos données. Peut-être avez-vous besoin d’extraire des données d’un site Web qui est le vôtre ou celui de votre partenaire de manière structurée. Mais il n’y a pas de moyen interne facile de le faire et il est logique de créer un grattoir et de simplement récupérer ces données. Au lieu d’essayer de vous frayer un chemin à travers des systèmes internes compliqués.

Surveillance de la PMA

La surveillance du prix minimum annoncé (MAP) est la pratique standard pour s’assurer que les prix en ligne d’une marque sont alignés sur sa politique de prix. Avec des tonnes de revendeurs et de distributeurs, il est impossible de surveiller les prix manuellement. C’est pourquoi le web scraping est pratique car vous pouvez garder un œil sur les prix de vos produits sans lever le petit doigt.

Comment puis-je extraire gratuitement des données d’un site Web ?

Il existe diverses solutions de grattage gratuites qui vous permettent d’automatiser le processus d’extraction de données à partir du Web. Celles-ci vont de simples solutions de grattage pointer-cliquer destinées aux non-spécialistes à des applications plus puissantes axées sur les développeurs avec des options de configuration et de gestion étendues.

Si vous consultez un site Web, comme vous le faites actuellement, vous pouvez simplement couper et coller les informations que vous lisez à l’écran dans un autre document, comme une feuille de calcul. C’est certainement un moyen d’extraire gratuitement des données Web. Mais la collecte manuelle d’informations de cette manière sera lente, inefficace et sujette aux erreurs pour toutes les tâches, sauf les plus simples.

En pratique, vous chercherez des moyens d’automatiser ce processus, vous permettant d’extraire des données de nombreuses pages Web – peut-être des milliers ou des millions d’entre elles par jour – et d’organiser les résultats dans une structure bien organisée. Pour ce faire, vous aurez besoin d’une sorte d’outil d’extraction de données Web, souvent appelé grattoir Web.

Il existe de nombreuses solutions de grattage gratuites pour extraire des données du Web. Certaines d’entre elles sont des applications dédiées destinées aux programmeurs, nécessitant un niveau de compétence en codage pour être configurées et gérées.

Idéal pour les non-spécialistes ayant des besoins d’extraction modérés, il existe également des grattoirs faciles à utiliser qui fonctionnent comme une extension de navigateur ou un plug-in avec une simple interface pointer-cliquer. Moins sophistiqués que leurs homologues axés sur les développeurs, ils sont généralement plus limités dans la variété et le volume de données qu’ils vous permettent de récupérer.

Découvrez nos derniers articles de blog

Pourquoi confier sa stratégie publicitaire à des experts Ads en 2025

Création de stands à Bordeaux : la solution idéale pour compléter votre référencement local ?

Création de stands à Bordeaux : la solution idéale pour compléter votre référencement local ?

Création de stands à Bordeaux : la solution idéale pour compléter votre référencement local ?

Pourquoi Mettre en Place des Automatisations ? Les Raisons Incontournables pour Votre Business

Être visible sur Google ne relève plus du bonus stratégique. Aujourd’hui, c’est une condition de survie pour toute entreprise souhaitant se démarquer à Nice