Le crawling: processus pour extraire et évaluer les mots des pages web

Qu'est-ce qu'un crawling robot et quel est le processus pour extraire et évaluer les mots des pages web?

Un robot d’exploration Web, également connu sous le nom d’araignée Web ou de robot de moteur de recherche, est un robot qui visite et indexe le contenu des pages Web partout sur Internet. Avec une telle quantité d’informations, un moteur de recherche sera en mesure de présenter à ses utilisateurs des informations pertinentes dans les résultats de recherche.

Plan de l’article :

Qu'est-ce qu'un Web Crawler ?

L’objectif d’un robot d’exploration Web ou crawling robot est d’obtenir des informations, souvent de continuer à obtenir de nouvelles informations pour alimenter un moteur de recherche.

Si un moteur de recherche est un supermarché, ce qu’un robot d’indexation fait est comme un grand sourcing – il visite différents sites Web/pages Web, navigue et stocke les informations dans son propre entrepôt. Lorsqu’un client vient et demande quelque chose, il y aura certains produits à offrir sur les étagères.

Il s’approvisionne en indexant les pages Web et le contenu qu’elles contiennent. Le contenu indexé sera prêt à être récupéré et lorsqu’un utilisateur recherche une requête particulière, il pourra présenter à l’utilisateur les informations les plus pertinentes.

Un robot d’exploration Web est un super bourreau de travail ou il doit en être un. Ce n’est pas seulement parce qu’il y a un nombre énorme de nouvelles pages créées chaque minute dans le monde (environ 252 000 nouveaux sites Web sont créés chaque jour dans le monde selon Siteefy), mais aussi en raison des changements et des mises à jour de ces pages.

Certains robots d’exploration Web sont actifs sur Internet :

- Googlebot

- Bingbot

- Yandexbot

- Alexabot

Ils sont principalement destinés aux moteurs de recherche. Malgré les robots d’exploration Web qui fonctionnent pour un moteur de recherche, certains robots Web collectent des informations sur les sites Web à des fins de référencement, telles que l’audit du site et l’analyse du trafic. Au lieu d’offrir des résultats de recherche aux utilisateurs de moteurs de recherche, ils fournissent des informations précieuses aux propriétaires de sites Web (comme Alexa).

Travaillez avec les pros du SEO

Audit technique, création de contenu, optimisation SEO...

Le processus pour extraire et évaluer les mots des pages web?

Puisque vous avez une idée de base de ce qu’est un robot d’exploration Web, vous vous demandez peut-être comment fonctionne un robot d’exploration Web.

Il existe un grand nombre de pages Web disponibles sur Internet et leur nombre augmente rapidement chaque jour.

Comment un robot d’exploration Web les survole-t-il tous ?

En fait, tout le contenu sur Internet n’est pas indexé par les robots d’indexation. Certaines pages ne sont pas ouvertes aux robots des moteurs de recherche (#) et certaines n’ont tout simplement pas la possibilité d’en rencontrer.

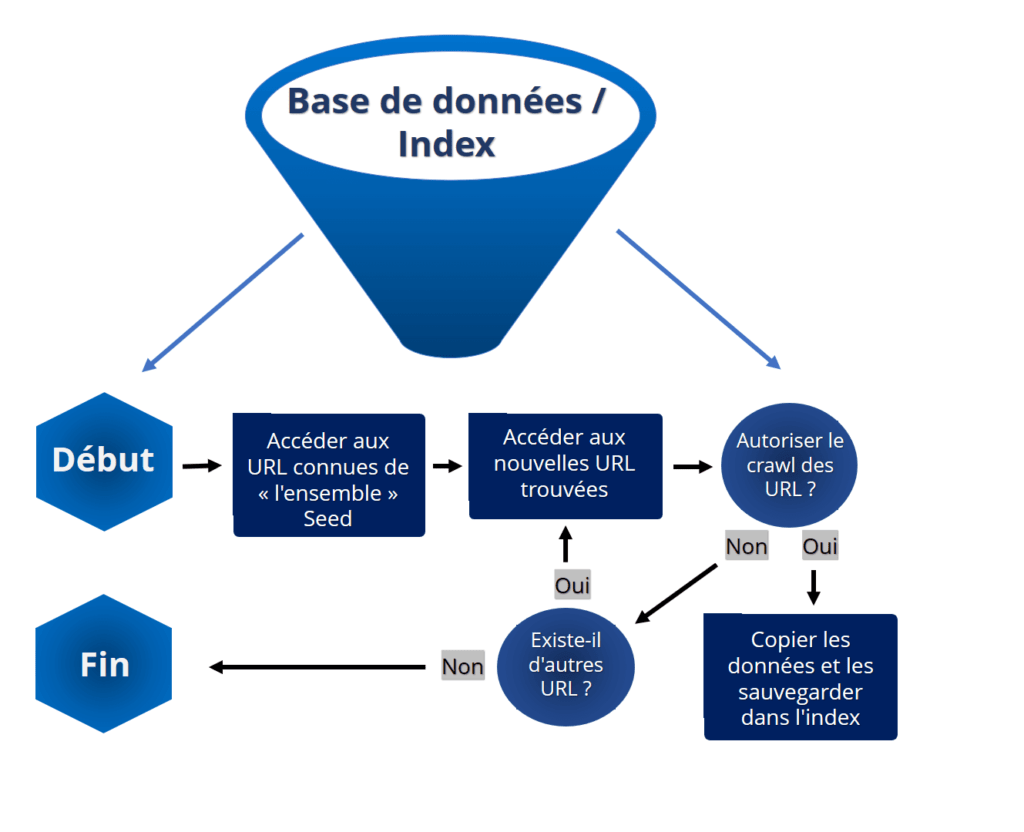

Le processus démarre via des URLs connus

Normalement, un robot d’exploration Web commence son voyage à partir d’un ensemble d’URL connues, ou ce qu’on appelle des URL de départ. Il parcourt les méta-informations des pages Web (par exemple le titre, la description) ainsi que le corps de la page Web. Au fur et à mesure que ces pages sont indexées, le robot d’exploration continue de parcourir les hyperliens pour visiter les pages Web qui sont liées dans les pages de départ.

Voici donc l’itinéraire de base qu’un robot d’exploration Web emprunterait :

- Accéder à la liste des pages Web connues

- Extraire les URL qui sont liées dans ces pages Web et ajoutez-les à la liste

- Continuez à visiter les pages nouvellement ajoutées

En visitant constamment les pages Web, les robots d’exploration Web peuvent découvrir de nouvelles pages ou URL, mettre à jour les modifications apportées aux pages existantes et marquer ces liens morts.

Les robots d’exploration Web donnent la priorité

Même si les robots d’exploration Web sont des programmes automatisés, ils ne peuvent pas suivre le rythme de l’expansion rapide d’Internet et des changements constants des pages Web. Afin de capturer les informations les plus pertinentes et les plus précieuses, les robots d’exploration Web doivent suivre certaines règles qui permettent de hiérarchiser tous les liens ajoutés, à visiter en premier.

Par exemple:

- Les pages Web qui sont liées par de nombreuses autres pages pertinentes seront considérées comme plus informatives que ces pages sans aucune référence. Les robots d’exploration Web sont plus susceptibles de donner la priorité à la visite de ces pages Web.

Les robots d’exploration Web revisitent les pages Web pour s’assurer qu’ils suivent les mises à jour et obtiennent de nouvelles informations. Une page Web mise à jour régulièrement peut être explorée plus fréquemment que celles qui apportent rarement des modifications. - Toutes ces règles sont faites pour aider l’ensemble de ce processus à être plus efficace et à être plus sélectionné sur le contenu qu’ils explorent. L’objectif est de fournir les meilleurs résultats de recherche aux utilisateurs des moteurs de recherche.

À propos de l’indexation

Un index de recherche aide un moteur de recherche à renvoyer des résultats rapidement et efficacement. Cela fonctionne comme un index dans un livre – pour vous aider à accéder rapidement aux pages (informations) nécessaires avec une liste de mots-clés (ou chapitres).

Le robot construit l’index. Il visite les pages du site Web, collecte le contenu, le place dans un index et l’envoie à la base de données. Vous pouvez prendre l’index comme une énorme base de données de mots et de pages correspondantes où ils apparaissent.

Pour les webmasters, il est important de s’assurer que le site Web est correctement indexé. Ce n’est que lorsque la page Web est indexée qu’elle apparaîtra dans les résultats de recherche et sera découverte par le public. Alors qu’un propriétaire de site Web peut également décider comment un robot de recherche explore son site Web. Robots.txt est un fichier que les webmasters créent pour indiquer aux robots de recherche comment explorer leurs pages.

Comment l'exploration Web(crawling) affecte-t-elle le référencement SEO?

1. être crawlé via des backlinks de haute qualité

Un bot d’exploration Web démarre à partir d’une liste d’URL de départ et ce sont normalement des pages de qualité provenant de sites Web de haute autorité. Si la page que vous souhaitez classer est liée par ces pages, elle sera certainement explorée par le bot. Nous ne savons pas quelles sont les URL de départ, mais vous êtes plus susceptible d’être exploré si vous avez plus de backlinks, en particulier lorsqu’ils proviennent de sites Web performants. En bref, il est essentiel de gagner plus de liens externes vers votre site Web, en particulier à partir de pages pertinentes et de haute qualité.2. être indexé avec des pages qui contiennent du contenu original

Votre page peut être explorée mais pas indexée. Le bot d’exploration Web est sélectif. Il ne stockera pas tout ce qu’ils ont vu dans l’index de recherche. Il existe un moyen de savoir combien de pages de votre site Web sont indexées par Google – saisissez « site : votre domaine » et effectuez une recherche sur Google.Si vous voulez savoir exactement quelles pages sont indexées et lesquelles ne le sont pas, les données sont disponibles sur Google Search Console : Google Search Console < Index < Coverage

Alors, quel type de contenu est indexé (par Google par exemple) ? De nombreux facteurs influents interviennent alors que la première chose à faire est d’écrire du contenu original. La mission de Google est d’offrir un contenu de valeur à ses utilisateurs. C’est presque la même chose pour tous les moteurs de recherche et le contenu dupliqué est toujours la cible de sanctions. Effectuez une recherche d’intention de recherche et de mots-clés. Écrivez et racontez votre propre histoire ou opinion.

Votre stratégie de marketing web

Tout compris, sur mesure, avec une agence web de confiance.

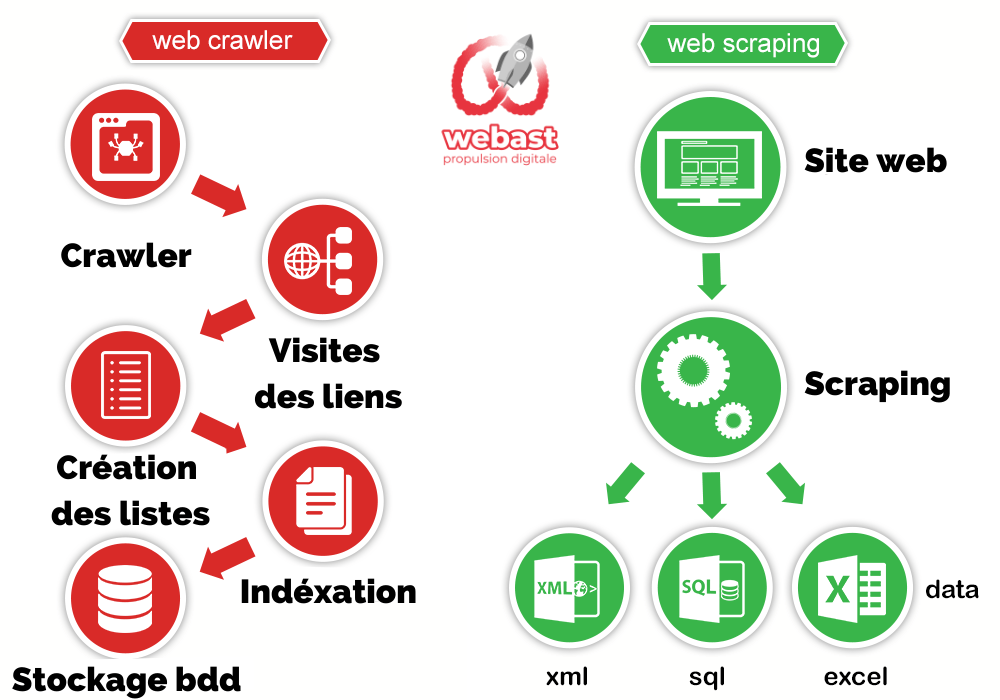

Différences entre le Web Crawling et le Web Scraping

Parfois, l’exploration Web et le grattage Web sont utilisés de manière interchangeable. Cependant, ils sont appliqués dans des scénarios très différents à des fins différentes. L’exploration Web consiste en un robot de moteur de recherche explorant des pages inconnues à stocker et à indexer, tandis que le grattage Web consiste à cibler une certaine liste d’URL ou de domaines et à extraire les données nécessaires dans des fichiers pour d’autres utilisations.

Le web scraping et le web crawling fonctionnent différemment.

Comme nous l’avons mentionné ci-dessus, l’exploration Web commence à partir d’une liste d’URL de départ et continue de visiter ce qui est lié pour étendre la portée à des pages plus inconnues. Même si un robot d’exploration peut avoir un ensemble de règles pour décider quelle page visiter avant les autres, il n’a pas de liste fixe d’URL ni ne se limite à un certain type de contenu.

Cependant, le web scraping a sa cible claire. Qu’est-ce que le web scraping?

Les utilisateurs accèdent au web scraping avec une liste d’URL ou de domaines et savent exactement quelles données ils capturent à partir de ces pages.

Par exemple, un vendeur de chaussures peut vouloir télécharger les informations sur les fournisseurs de chaussures d’Aliexpress, y compris le nom du fournisseur, les spécifications du produit et les prix. Un grattoir Web visitera le domaine (Aliexpress), recherchera un mot-clé pour obtenir une liste d’URL pertinentes, visitera ces pages et localisera les données nécessaires sur le fichier HTML et les enregistrera dans un document.

Ils ont des objectifs différents.

Le crawling Web consiste à explorer et à scruter le plus de pages possible, à indexer celles qui sont utiles et à les stocker dans la base de données afin de construire un moteur de recherche efficace.

Un grattoir Web peut fonctionner à des fins très différentes. Les gens peuvent l’utiliser pour recueillir des informations pour la recherche, des données pour la migration d’une plate-forme à une autre, des prix pour l’analyse des concurrents, des contacts pour la génération de prospects, etc.

Ils ont une chose en commun – ils s’appuient tous les deux sur un programme automatisé pour rendre le travail (impossible pour un humain) réalisable.

Pour en savoir plus sur le Web Scraping

Parfois, l’exploration Web et le grattage Web sont utilisés de manière interchangeable. Cependant, ils sont appliqués dans des scénarios très différents à des fins différentes. L’exploration Web consiste en un robot de moteur de recherche explorant des pages inconnues à stocker et à indexer, tandis que le grattage Web (scraping web) consiste à cibler une certaine liste d’URL ou de domaines et à extraire les données nécessaires dans des fichiers pour d’autres utilisations.

Comment s'appelle le processus de collecte ?

Le Crawling, “collecte” ou ”indexation” est un algorithme utilisé par Google et son outil Google Search pour déterminer le classement des sites internet dans les résultats des moteurs de recherche.

Lorsque vous faites une recherche dans Google, c’est donc grâce au Crawling fait au préalable que Google détermine qui est premier, deuxième, troisième dans votre résultat de recherche. pour classer les sites Web dans les résultats de leurs moteurs de recherche.

Comment le moteur Répond-il finalement à une recherche ?

Un moteur de recherche comme Google fonctionne grâce à un grand nombre de serveurs appelés spiders, robots ou crawlers qui sont chargés de parcourir les liens des millions de pages Web qui poitent les unes vers les autres, en indexant le contenu sur le chemin dans de gigantesques bases de données.

Cela permet ensuite à Google de découvrir, analyser et finalement classer les résultats de recherche selon la pertinence du contenu, de la vitesse et d’autres facteurs SEO.

Comment procède un moteur de recherche pour enregistrer en analyser le contenu des milliards de pages qui composent le Web ?

Lorsque le spider, crawler ou robot de Google Search à visité votre page, il va l’enregistrer dans des énormes bases de données qui regroupent justement les informations de milliards de page web.

Par après, Google extrait ses informations, les analyses, puis les trie, cela donne les résultats de recherche, ou l’ordre ou apparait votre page sur une requête donnée.

Comment crawler un site web ?

Il existe de nombreux outils afin de crawler votre site internet pour découvrir par exemples vos URLs, vos pages HTML, vos pages uniquement Javascript, vos images… mais aussi vos pages qui ne fonctionnent pas (404 par exemple).

Nous conseillons l’outil de crawling Screaming Frog Spider (crawler gratuit jusquà’500 URLs, puis payant).

Comment les moteurs de recherche repèrent les pages web ?

Les moteurs de recherche crawlent d’abord les sites, en parcourant certaines pages et en analysant le contenu. En fonction de nombreux facteurs SEO comme par exemple le nombre de visites ou le nombre de sites qui ont des liens vers ce site.

Ensuite, en tapant les mots-clés correspondant à ses pages, si elles sont considérées par Google comme suffisamment pertinentes pour être le meilleur contenu associé à un mot-clé. C’est toute la science et la difficulté du SEO.

Découvrez nos derniers articles de blog

Rebranding : quand et comment changer de nom sans perdre son audience ?

Avant d’engager une telle transformation, vous devez nécessairement identifier les raisons profondes qui motivent un tel choix et recenser toutes les implications que cela pourrait induire.

Quels sont les enjeux de la transformation digitale en 2025 ?

Vous imaginez pouvoir gérer tous vos appels depuis n’importe quel endroit du monde sans dépendre d’un téléphone fixe?

Tout ce que vous devez savoir sur la téléphonie VoIP

Vous imaginez pouvoir gérer tous vos appels depuis n’importe quel endroit du monde sans dépendre d’un téléphone fixe?